اپل برنامه جنجالی CSAM را برای همیشه کنار گذاشته است

با توجه به این ادعا که سیمی به اشتراک گذاشته شد، اپل امروز اعلام کرد که با شروع از برنامه جنجالی خود برای شناسایی مواد شناخته شده استثمار جنسی از کودکان (CSAM) که در iCloud Photos ذخیره شده است، حذف شده است.

خاموش شدن کامل ابتکار CSAM اپل

بیانیه کامل اپل به شرح زیر است:

“پس از مشاوره گسترده با کارشناسان برای جمعآوری بازخورد در مورد طرحهای حمایت از کودکان که سال گذشته پیشنهاد کردیم، در حال تعمیق سرمایهگذاری خود در ویژگی امنیت ارتباطات هستیم که برای اولین بار در دسامبر 2021 در دسترس قرار دادهایم. همچنین تصمیم گرفتهایم تا این برنامه را متوقف کنیم. CSAM. کودکان را می توان بدون استفاده از اطلاعات شخصی توسط شرکت ها محافظت کرد، و ما به همکاری با دولت ها، حامیان کودکان و سایر شرکت ها برای کمک به محافظت از جوانان، محافظت از حریم خصوصی آنها و تبدیل اینترنت به مکانی امن برای کودکان و همه ادامه خواهیم داد.»

در آگوست 2021، اپل برنامههایی را برای سه ویژگی جدید ایمنی کودک اعلام کرد، از جمله سیستمی برای شناسایی تصاویر CSAM ذخیره شده در iCloud Photos، یک گزینه ایمنی ارتباطات که عکسهای تلقینکننده جنسی را در برنامه پیامها و منابع کودک آزاری حذف میکند. امنیت ارتباطات در دسامبر 2021 با iOS 15.2 در ایالات متحده راه اندازی شد و از آن زمان به بریتانیا، کانادا، استرالیا و نیوزلند با منابع Siri در دسترس است، اما ویژگی تشخیص CSAM هرگز راه اندازی نشد.

اپل ابتدا اعلام کرد که تشخیص CSAM در بهروزرسانیهای iOS 15 و iPadOS 15 تا پایان سال 2021 اجرا میشود، اما این شرکت در نهایت این ویژگی را بر اساس «بازخورد مشتریان، گروههای مدافع، محققان و دیگران» به تعویق انداخت. اکنون، پس از یک سال سکوت، اپل به طور کامل برنامه های تشخیص CSAM را کنار گذاشته است.

خاموش شدن کامل ابتکار CSAM اپل

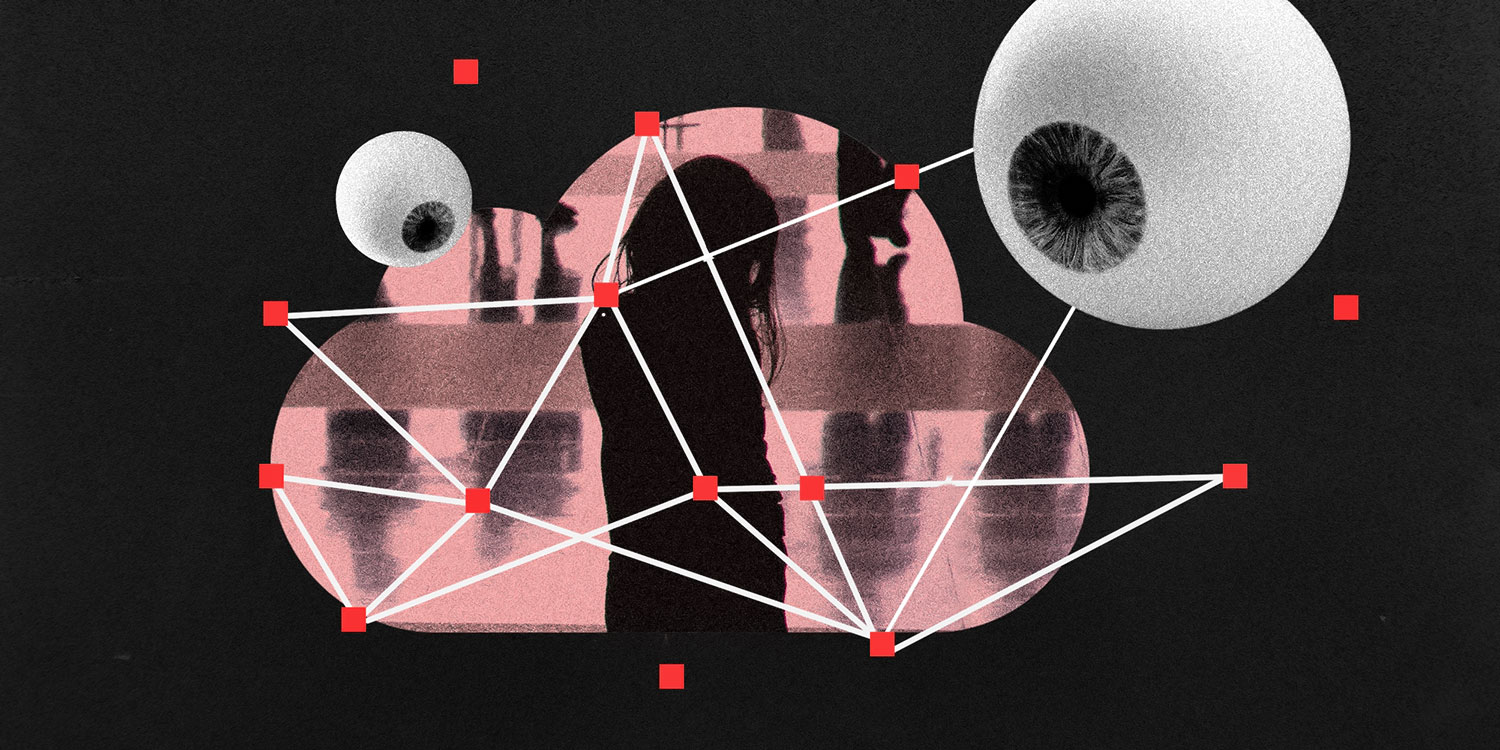

اپل قول داده است که سیستم تشخیص CSAM آن “با در نظر گرفتن حریم خصوصی کاربر طراحی شده است”. این سیستم میتواند «تطابق روی دستگاه را با استفاده از پایگاهداده تصویر CSAM» از آژانسهای ایمنی کودکان انجام دهد، که اپل آن را به «مجموعهای ناخوانا تبدیل میکند که به طور ایمن در دستگاههای کاربر ذخیره میشود».

اپل قصد داشت حسابهای iCloud حاوی تصاویر CSAM را به مرکز ملی کودکان گمشده و مورد بهرهکشی (NCMEC)، یک سازمان غیرانتفاعی که با مجریان قانون ایالات متحده همکاری میکند، گزارش کند.

اپلیکیشنهای اپل توسط طیف وسیعی از افراد و سازمانها از جمله محققان امنیتی، بنیاد مرز الکترونیک (EFF)، سیاستمداران، گروههای سیاسی، محققان دانشگاهی و حتی مورد انتقاد قرار گرفتهاند. برخی از کارمندان اپل مورد انتقاد قرار گرفته است.

برخی از منتقدان استدلال کردند که این ویژگی یک “درپشتی” در دستگاه هایی ایجاد می کند که دولت ها یا مجریان قانون می توانند از آن برای نظارت بر کاربران استفاده کنند. نگرانی دیگر درباره موارد مثبت کاذب بود، از جمله احتمال اینکه شخصی عمداً تصاویر CSAM را به حساب iCloud شخص دیگری اضافه کند تا حساب خود را پرچم گذاری کند.

نظر شما در مورد خاموش شدن کامل CSAM توسط اپل چیست؟

برای دوستان خود ارسال کنید